Para esta entrada se leyó el siguiente paper y se escribió un pequeño resumen acerca de lo más importante que ahí se trata:

Underwater Sensor Networking: Research

Challenges and Potential Applications

Autores: John Heidemann, Yuan Li, Affan

Syed, Jack Wills, Wei Ye

El uso de redes sensoras en ambientes

marítimos tiene grandes aplicaciones como el monitoreo de la actividad en

yacimientos de petróleo, monitoreo de actividades sísmicas o simplemente

controlar robots que se desplacen por el agua.

La idea central del paper es trasladar

todo lo logrado de estas redes en el ámbito terrestre a el ámbito marítimo, es

decir reproducir las mismas condiciones de conexión (las amplias zonas de

cobertura), el bajo consumo energético, la fácil comunicación entre nodos, la

gran población, el precio (en el paper mencionan 100 USD por nodo ), todo esto

es lo contrario en el apartado marítimo, pequeñas zonas de cobertura, la

comunicación generalmente se hace hacia un nodo central, la población es

pequeñas y el alto precio (mencionan +10K USD por nodo).

La idea es tratar de acercar lo más

posible el aspecto marítimo a las condiciones que se tienen en el ámbito

terrestre.

Se basan en el desarrollo de un sistema

de monitoreo de yacimientos de petróleo, lo hacen solo con el fin de basarse en

algo para explicar y también en el hecho de que esta opción es más barata y

eficiente que el sistema tradicional.

Los principales desafíos son trasladar

lo que se tiene de manera terrestre a marítimo, el primer desafío es la

comunicación inalámbrica ya que mientras en el lado terrestre se puede usar

wifi o bluetooth, dentro del mar la transmisión de las ondas de radio en el

agua no es muy buena y suele limitarse a 1 máximo de alcance.

Debido a esto la opción más fiable es “Telemetría

Acústica” donde la comunicación se hará por medio de ondas de sonido que son

más propagables dentro del agua que las de radio.

El segundo punto es que debido al cambio

de medio de comunicación la velocidad de transmisión disminuye, de la velocidad

de la luz (3x108m/s) a la velocidad del sonido (1.5x103m/s),

por lo que el flujo de información se vería afectado inmediatamente.

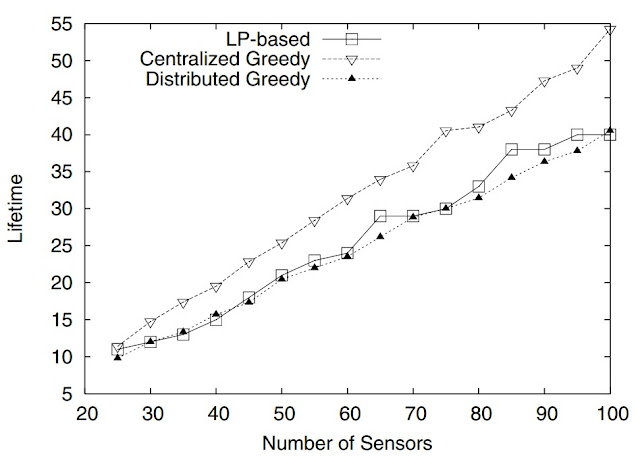

Otro punto desafiante es el manejo de

energía, ya que los nodos terrestres son

más sencillos y por lo tanto consumen menos energía todo lo contrario de los

sensores que se usaran bajo el agua ya que son más complejos y más grandes, por

lo que su consumo de energía es mucho mayor.

En la arquitectura del sistema que

plantean, se usan cuatro nodos diferentes y la imagen siguiente es la que toman

ellos como referencia para la construcción de su red sensora:

Los sensores ubicados casi al fondo del mar

son los encargados de obtener la información de los movimientos sísmicos o

yacimientos de petróleo y se comunican con los demás de manera acústica, lo que

se encuentran en la parte más alta se conectan directamente con estaciones que

salen del agua y que son operables por personas, además están conectados a

internet para compartir información.

Y los monitos azules suponen robots

sumergibles que son capaces conectarse directamente con los demás nodos y

sensores para compartir información de manera acústica.

Los nodos siempre estarán estáticos para

reducir los costos en la movilidad de los nodos además al tratarse del mar las

condiciones ambientales pueden cambiar mucho por lo que algunos nodos se pueden

perder, dañar o simplemente dejar de funcionar, por lo que se emplea un sistema

de comunicación redundante para que la información que un nodo envía se reenvíe

a todos los demás, así, si pierde ese nodo no significará grandes problemas

para todo el sistema y será una falta fácil de reparar.

Todo lo demás que se menciona son configuraciones necesarias para la instalación de este sistema por lo que no son de relevancia su tratamiento aquí.

Conclusiones:

Según lo que dice el paper, aplicaciones de este tipo aún son muy poco explotadas por lo que podría ser un buen punto de investigación.

Además de que las alternativas que se usan actualmente son mucho más costosas y menos eficientes que la mayoria, por ejemplo muchos de estos sistemas se comunican por medio de cables, algo que no es muy confiable dado a que se esta tratando en un medio físico para el cual los cables no si hicieron.

Una pérdida en un cable, podría garantizar la pérdida de mucha información además de tiempo y dinero solo para la información, ya que además sería necesario repararlo y esto resultaría en más tiempo y dinero.

Todo lo demás que se menciona son configuraciones necesarias para la instalación de este sistema por lo que no son de relevancia su tratamiento aquí.

Conclusiones:

Según lo que dice el paper, aplicaciones de este tipo aún son muy poco explotadas por lo que podría ser un buen punto de investigación.

Además de que las alternativas que se usan actualmente son mucho más costosas y menos eficientes que la mayoria, por ejemplo muchos de estos sistemas se comunican por medio de cables, algo que no es muy confiable dado a que se esta tratando en un medio físico para el cual los cables no si hicieron.

Una pérdida en un cable, podría garantizar la pérdida de mucha información además de tiempo y dinero solo para la información, ya que además sería necesario repararlo y esto resultaría en más tiempo y dinero.

Referencias:

"Underwater Sensor Networking: Research

Challenges and Potential Applications", " John Heidemann, Yuan Li, Affan Syed, Jack Wills,

Wei Ye ", http://ftp.isi.edu/~johnh/PAPERS/Heidemann05b.pdf